LLMの利用状況分析とAIによる合意形成、Reasoningモデルでの思考プロセス

2025/02/26 AI AI Agent Reasoning

概要

近年、Claudeに代表される大規模言語モデル(LLM)は、社会に広範な変革をもたらし、経済や労働市場の構造に深く影響を与えています。LLMの目覚ましい発展と普及は、労働市場の変容、業務効率の向上、そして経済成長の促進といった多岐にわたる可能性を示唆する一方で、雇用喪失や倫理的な懸念といった課題も引き起こしており、現代社会におけるテクノロジーと雇用の関係性を議論する上で、LLMは重要な分析対象となっています。 LLMの影響を正確に評価するためには、多様な業界におけるLLMの導入状況を把握し、その経済効果と倫理的課題を包括的に分析する必要があります。本稿では、定性的な調査と定量的な調査を組み合わせた体系的な方法論を用いてLLMを分析し、現状のAI技術の導入率、その分析手法、意見形成におけるAIの役割、そして推論モデルとしてのAIの特性について詳細に解説します。AI技術の採用率:現状の把握と課題

AI技術の導入率は、調査方法や対象、そして質問の仕方によって大きく異なることが、様々な調査結果から明らかになっています。例えば、国勢調査の公式データでは、企業レベルでのAI導入率はわずか5%と報告されています。しかし、労働者の雇用状況を加味した別の調査では、AI導入率が20%から40%に達するという結果も出ており、職場におけるAI技術の急速かつ広範な浸透を示唆しています。個人レベルの調査でも同様の傾向が確認されており、多くの従業員が日常業務でAIツールを活用し始めている実態が浮き彫りになっています。

このように、AI導入率の調査結果にばらつきが見られる背景には、AI技術の定義や調査対象とする範囲の違い、そして調査方法の多様性などが考えられます。しかし、これらの調査結果は、AI技術が社会の様々な分野で急速に採用され、その影響力が拡大していることを示唆している点で共通しています。

こうした状況を踏まえ、AIが人々の働き方や労働市場に与える長期的な影響をより深く理解するため、Anthropic社は「Anthropic Economic Index」という新たな取り組みを開始しました。この指標は、Claude.ai上で行われた数百万件もの匿名化された会話データを分析し、AIが現代経済の実態にどのように組み込まれているかについて、これまでになく明確な全体像を提供することを目的としています。

さらに、Anthropic社は、この分析に使用したデータセットをオープンソースとして公開しており、研究者がその調査結果に基づいて更なる研究を発展させることが可能です。労働市場の変革期において、雇用と生産性に及ぼす影響を正確に評価し、適切な政策対応を策定するためには、多様な視点からの分析が不可欠であり、データセットの公開は、研究コミュニティ全体の進歩を促進する上で重要な貢献となるでしょう。

Anthropic Economic Index の結果:AI利用の実態

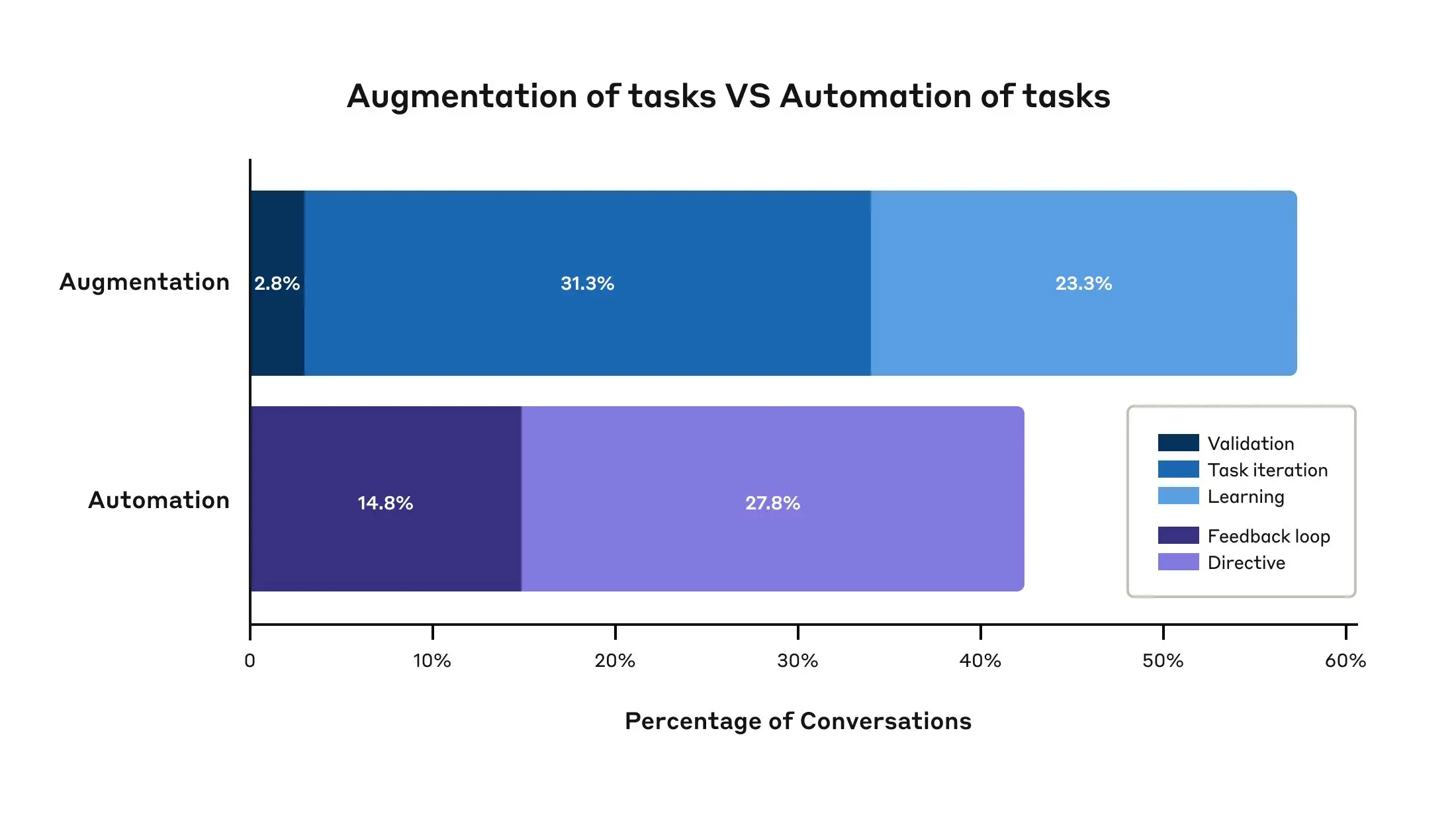

Anthropic Economic Index の分析結果から、現時点ではAIの利用は特定の業務領域に集中していることが明らかになりました。特に、ソフトウェア開発とテクニカルライティング業務での利用が顕著です。具体的には、**3分の1を超える職業(約36%)**で、関連業務の少なくとも4分の1にAIが使用されており、**約4%の職業**では、関連業務の4分の3以上にAIが活用されているという結果が出ています。興味深いことに、AIの利用形態は、AIがタスクを完全に代行する自動化(43%)よりも、AIが人間の能力を支援・強化する**増強(57%)**にやや偏っていることが示されました。これは、現時点ではAIが人間の仕事を完全に代替するのではなく、人間の能力を拡張し、より効率的かつ創造的な働き方を支援するツールとして活用されている傾向が強いことを示唆しています。

また、AIの利用は、コンピュータープログラマーやデータサイエンティストのような中・高賃金職に関連するタスクでより普及している一方、低賃金職と高賃金職の両方での利用は低い傾向にあります。この背景には、現在のAI能力の限界と、技術導入に対する現実的な障壁の両方が影響していると考えられます。例えば、高度な専門知識や複雑な判断を要する高賃金職では、AIがまだ十分な能力を発揮できない場合があります。一方、単純労働や反復作業が多い低賃金職では、AI導入のコスト対効果が低い、あるいは既存の業務プロセスを変革する必要があるなどの理由で、導入が進んでいない可能性があります。

労働市場におけるAI利用のマッピング:分析手法の詳細

Anthropic Economic Index の分析は、テクノロジーが労働市場に与える影響に関する長年の研究に基づいて設計されています。産業革命期の紡績機から現代の自動車製造ロボットに至るまで、技術革新は常に労働市場に変化をもたらしてきました。本研究は、過去の技術革新の影響を参考にしつつ、現代におけるAI、特にLLMが労働市場に与える影響を直接的なデータに基づいて分析することを試みています。従来の労働経済学研究とは異なり、本研究では、AI利用に関する人々の主観的な評価や将来予測に頼るのではなく、Claudeとの実際の会話データという客観的なデータを用いて分析を行っています。これにより、AIが実際にどのような業務で、どのように利用されているのかをより詳細かつ正確に把握することが可能になります。

職業タスクの分析:O*NETとClioの活用

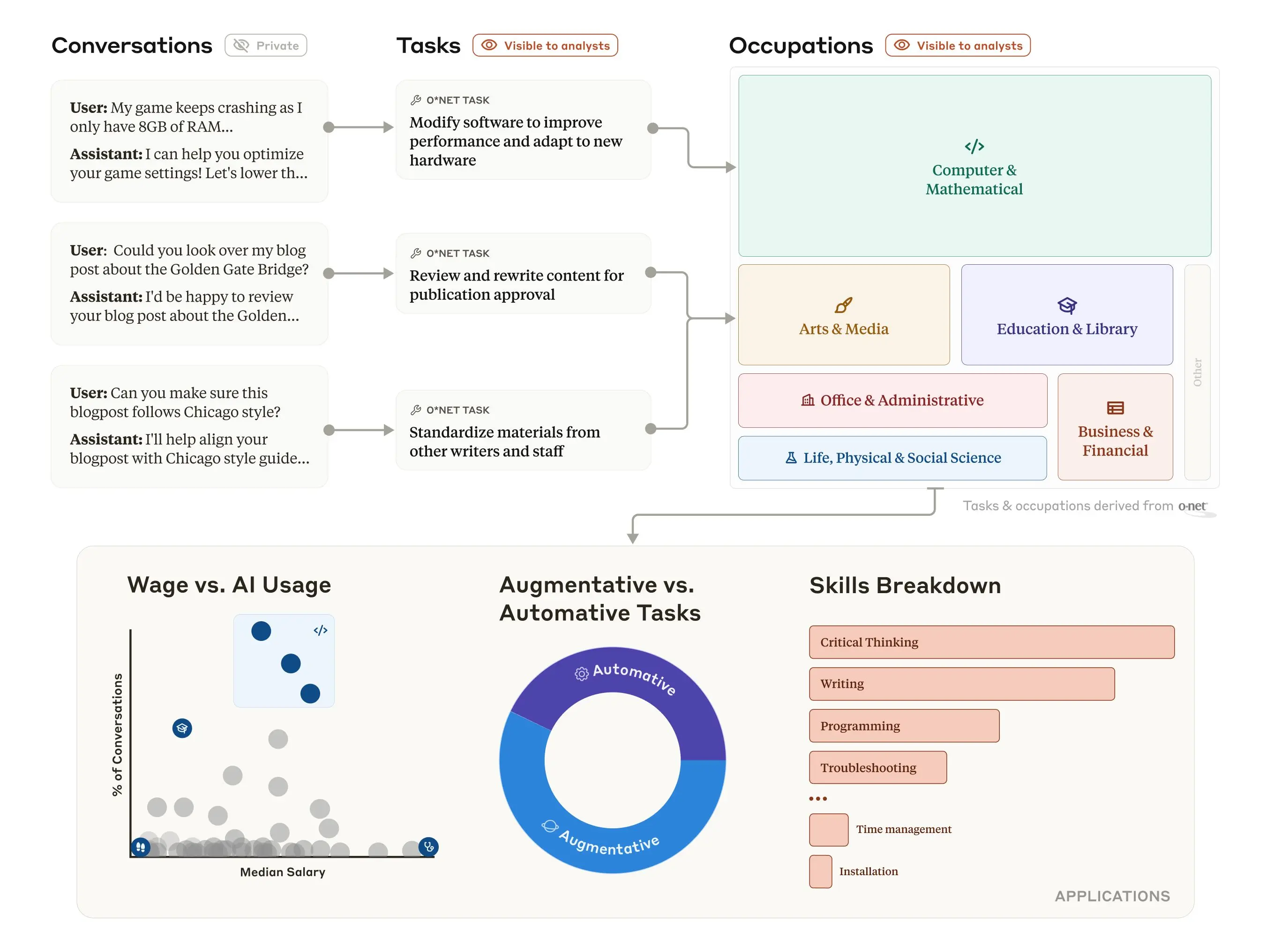

本研究は、経済学の文献から得られた重要な洞察、例えば「視覚的なパターン認識は、デザイナー、写真家、警備員、放射線技師など、多くの職業に共通する重要なタスクである」といった知見を出発点としています。特定の仕事は、他の仕事よりも新しいテクノロジーによる自動化や増強に適しているという前提に基づき、AIは様々な職業における特定のタスクに選択的に採用されると予想されます。したがって、職業全体だけでなく、個々のタスクレベルでAIの利用状況を分析することで、AIが経済にどのように統合されているのかをより深く理解することができます。この分析を実現するために、Anthropic社は、ユーザーのプライバシーを保護しながらClaudeとの会話を分析できる自動分析ツール「Clio (Claude insights and observations)」を開発しました。Clioは、Claude.ai上のFreeおよびProプランにおける約100万件の会話データセットを分析し、各会話を職業別のタスクに整理するために使用されました。

職業分類には、米国労働省が管理する職業情報ネットワーク(O*NET)が活用されました。O*NETは、約20,000種類の特定の仕事に関連する詳細な職務データベースを提供しています。Clioは、各会話の内容を分析し、その会話におけるAIの役割を最も良く表すO*NETタスクを特定し、紐付けました。このプロセスを経て、タスクはO*NETの分類体系に従って、最も関連性の高い職業にグループ化され、さらに教育・図書館、ビジネス・金融などのより広範なカテゴリーに分類されました。

研究成果:職種別、利用深度、給与との関係性

職種別のAI利用状況:ソフトウェア開発とクリエイティブ領域での顕著な利用

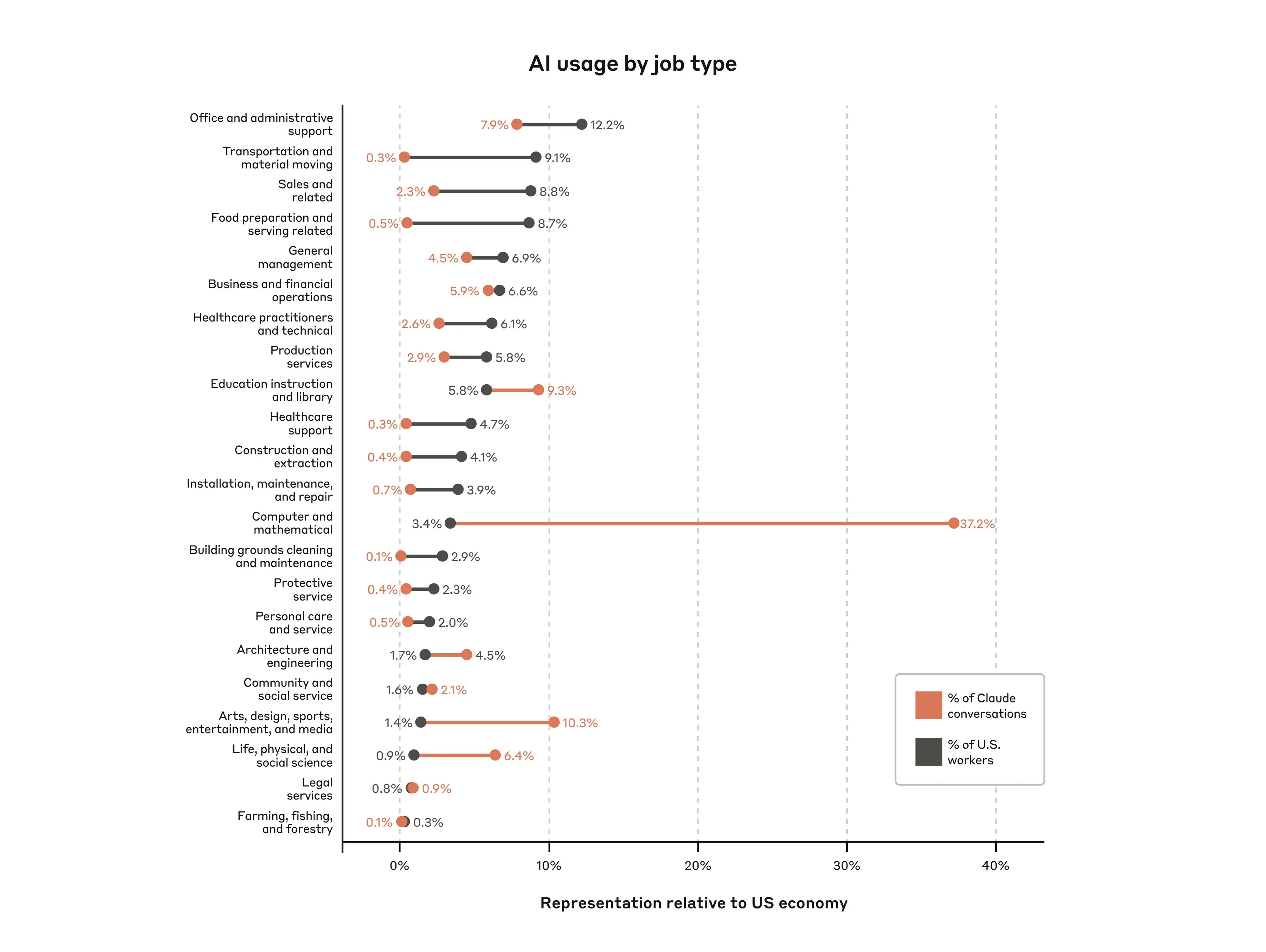

Anthropic Economic Index の分析結果から、ClaudeのデータセットにおいてAIが最も多く採用されているタスクと職種は、「コンピュータと数学」のカテゴリーに属するものであることが明らかになりました。このカテゴリーは、主にソフトウェアエンジニアリング関連の職務をカバーしており、クエリ全体の**37.2%**を占めています。具体的なタスクとしては、ソフトウェアの修正、コードのデバッグ、ネットワークのトラブルシューティングなどが挙げられます。2番目に多いカテゴリーは、「アート、デザイン、スポーツ、エンターテイメント、メディア」(クエリの**10.3%**)で、主に様々な種類の執筆や編集作業にClaudeを利用している人々が多いことを反映しています。一方、当然ながら、「農業、漁業、林業」(クエリの**0.1%**)のような肉体労働を主とする職業での利用は最も少ない結果となりました。

さらに、各職業が労働市場全体に占める割合と比較することで、AI利用の偏りが見えてきます。例えば、ソフトウェア開発関連職は、労働市場全体に占める割合は比較的小さいものの、AI利用においては圧倒的な割合を占めています。これは、現在のAI技術が、特定の専門スキルを必要とする職種、特に知識労働やクリエイティブな業務において、より効果的に活用されていることを示唆しています。

職業内でのAI利用の深さ:限定的ながら広がる浸透

分析によると、関連業務のほとんど全てでAIが使用されている職種はごく一部に限られています。しかし、より緩やかなAIの利用はより広範囲に広がっており、約36%の職種が少なくとも25%の業務でAIを利用しているという結果が出ています。このデータは、AIが特定の職種に集中するのではなく、経済全体の多くの仕事に徐々に浸透しつつある現状を示唆しています。また、今回のデータセットからは、仕事が完全にAIによって自動化されたという明確な証拠は見られませんでした。むしろ、AIは経済における多くの仕事に拡散しており、職種によって影響の強さに差があるものの、広範な職種で何らかの形でAIが活用されていることが示唆されています。

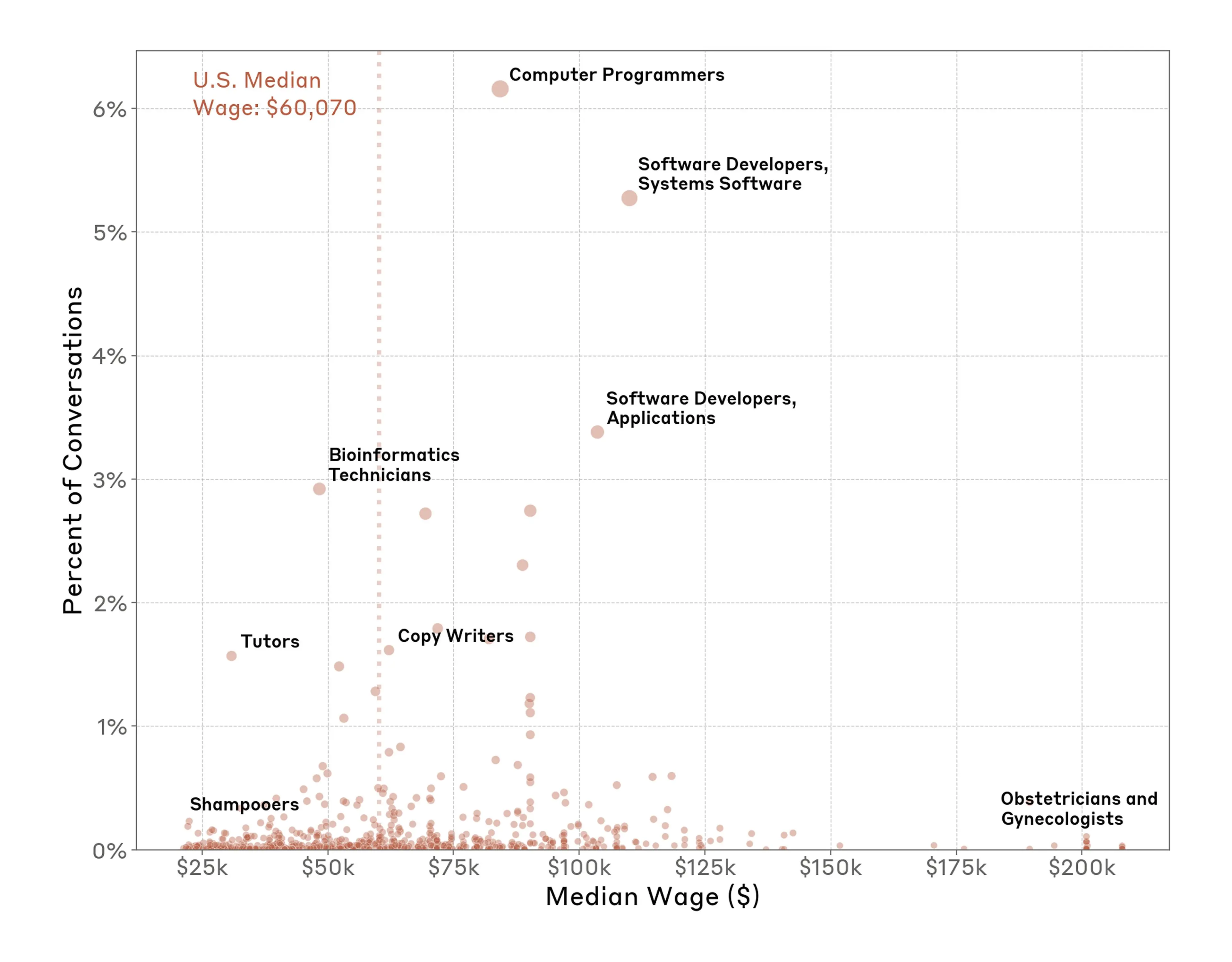

AIの利用と給与:中〜高賃金職での利用が活発

O*NETデータベースに登録されている各職業の米国における給与中央値と、対応する業務におけるAIの使用レベルを比較分析した結果、興味深い傾向が明らかになりました。**低賃金職と非常に高賃金職**では、AIの使用率が比較的低いことがわかりました。低賃金職の例としては、手作業や身体的な労働が中心となる職業(例:シャンプー職人)が挙げられます。一方、高賃金職の例としては、高度な専門知識や対人スキルが求められる職業(例:産科医)などが該当します。これらの職業では、現時点ではAIが人間の能力を完全に代替したり、大幅に効率化することが難しいと考えられます。

対照的に、**給与中央値が中〜高の特定の職業**、例えばコンピュータープログラマーやコピーライターなどは、今回のデータにおいてAIのヘビーユーザーであることが示されました。これらの職種は、知識労働が中心であり、AIが情報収集、分析、文章作成などのタスクを効率化する上で有効に活用できると考えられます。

自動化と増強:人間の能力を拡張するAIの役割

タスクの実行方法、具体的には、どのタスクが「自動化」(AIがタスクを直接実行)されているのか、それとも「増強」(AIがユーザーと協力してタスクを実行)されているのかを詳細に分析した結果、全体としてタスクの**57%**が「増強」、**43%**が「自動化」であり、「増強」にわずかながら偏りが見られました。この結果は、AIが人間の仕事を完全に代替するのではなく、むしろ人間の能力を拡張し、より高度な業務遂行を支援するツールとして活用されているケースが多いことを示唆しています。増強型AIの具体的な活用例としては、以下のようなものが挙げられます。

* **検証**: ユーザーの作成した文章やコードをダブルチェックし、誤りや改善点を見つける。

* **学習**: ユーザーが新しい知識やスキルを習得するのを支援する。

* **反復作業の支援**: ブレインストーミングやアイデア出しなど、繰り返し行う必要がある生成的なタスクをサポートする。

これらの例からわかるように、AIは人間の創造性や判断力を補完し、より効率的かつ質の高いアウトプットを生み出すための強力なパートナーとして機能していると言えるでしょう。

研究の限界:データと分析の制約

Anthropic Economic Index の分析は、AIが労働市場に与える影響を理解するための貴重な洞察を提供してくれますが、全てのリサーチと同様に、この研究にもいくつかの重要な限界が存在します。* **Claude利用者の職務状況の不確実性**: Claudeをタスクに使用している人が、そのタスクを仕事として行っているのか、あるいは個人的な目的で利用しているのかを区別することは困難です。例えば、執筆や編集のアドバイスを求めているユーザーが、仕事で執筆している可能性もあれば、趣味で書いている小説のために利用している可能性もあります。

* **回答の利用方法の不明確さ**: ユーザーがClaudeからの回答をどのように利用しているかはデータからは直接的に把握できません。例えば、コードの断片をコピー&ペーストしているのか、回答をファクトチェックしているのか、あるいは無批判に受け入れているのかなど、利用方法は様々であると考えられます。また、ユーザーがClaudeに完全なメモの作成を依頼し(自動化のように見える)、その後自分で編集を加える(増強)といった複合的な利用も考えられます。

* **データ対象の限定性**: 分析対象データは、Claude.aiのFreeおよびProプランのユーザーに限られており、API、Team、Enterpriseユーザーのデータは含まれていません。Claude.aiのデータには仕事以外の会話も含まれる可能性がありますが、言語モデルを用いて職業タスクに関連する会話のみを抽出することで、この懸念をある程度軽減しています。

* **タスク分類の誤りの可能性**: タスクの種類が非常に多岐にわたるため、Clioが一部の会話を誤って分類した可能性は否定できません。分析の検証方法の詳細については、論文全文、特に付録Bを参照する必要があります。

* **画像生成能力の欠如**: Claudeは画像を直接生成する機能を持たないため(コードによる間接的な生成を除く)、画像生成に関連するクリエイティブな利用はデータに反映されにくい可能性があります。

* **コーディングユースケースの過剰表現の可能性**: Claudeが最先端のコーディングモデルとして広く認知されていることを考慮すると、コーディング関連のユースケースがデータ上で過剰に表現されている可能性があります。したがって、このデータセットに含まれる利用例がAI使用全般を代表するサンプルであるとは断言できません。

これらの限界を考慮すると、Anthropic Economic Index の分析結果は、AIの労働市場への影響を完全に網羅的に捉えたものではなく、あくまで現時点での特定の側面を反映したものと理解する必要があります。

結論と今後の研究:AIと労働市場の未来

AIの利用は急速に拡大しており、LLMの能力も日々進化を続けています。労働市場の状況は、今後比較的短期間のうちに大きく変化する可能性があります。そのため、Anthropic Economic Index のような継続的な分析を通じて、社会経済の変化を追跡していくことが重要になります。Anthropic社は、今後も定期的に分析結果と関連データセットを公開し、「人間経済インデックス」の一部として提供していく予定です。このような縦断的な分析は、AIと雇用市場に関する新たな洞察をもたらすことが期待されます。例えば、職業におけるAI利用の深さの変化を継続的にモニターすることで、AIが特定の業務に限定的に使用される傾向が続くのか、それともより広範な業務で深く利用されるようになるのか、といった変化を捉えることができます。もしAIが特定の業務にのみ使用され、大部分の業務でAIを使用する職種が少数にとどまるのであれば、将来的に現在のほとんどの職種が完全に消滅するのではなく、AIによって進化していく可能性を示唆していると言えるでしょう。

また、自動化と増強の比率をモニターすることで、自動化がより普及していく分野の兆候を早期に捉えることも可能です。これらの分析を通じて、AI技術の進化が労働市場に与える影響を多角的に理解し、未来の労働市場の姿を予測するための重要な手がかりを得ることができるでしょう。

意見形成上でのAI代弁者:集団意思決定における新たな可能性

労働市場におけるAIの役割が拡大する一方で、AIは人々の意見形成や意思決定プロセスにも影響を与え始めています。特に、大規模言語モデル(LLM)は、自然言語処理能力を駆使して、人間の意見を理解し、応答するだけでなく、**意見形成の過程を支援したり、時には人間の代弁者として意見を表明したりする**可能性を秘めています。近年、「Language Agents as Digital Representatives in Collective Decision-Making」という研究が発表され、AIが意見形成の場で人間の代弁者となる可能性を探求しています。この研究では、AI代弁者が集団意思決定プロセスにどのように関与し、合意形成にどのような影響を与えるかを検証しています。以下では、この研究に基づいて、AI代弁者の有用性と課題について考察し、**AIが単なる労働ツールから、社会的な意思決定プロセスに関与するパートナーへと進化する可能性**について議論します。

研究の背景:言語エージェントと集団意思決定

言語エージェントとは、自然言語処理(NLP)技術を活用し、人間と自然な言語でコミュニケーションを取り、意思決定プロセスを支援するAIシステムです。これらのエージェントは、集団意思決定においてデジタル代表として機能し、人間の意思決定をサポートする役割を担います。集団意思決定は、多くの場合、複数の利害関係者が関与し、異なる意見や価値観を調整する必要があるため、言語エージェントの役割は非常に重要となります。言語エージェントは、情報提供、議論の促進、意思決定の自動化など、集団意思決定プロセスの様々な段階で貢献することが期待されています。言語エージェントの開発は、AI技術、特に大規模言語モデル(LLM)の進化とともに急速に進展しています。LLMは、テキスト生成や理解だけでなく、複雑な意思決定プロセスにおけるエージェントの行動を制御するためにも活用されています。例えば、LLaMACというモジュラーフレームワークは、LLMベースのエージェントを大規模な意思決定に適用するためのもので、LLM特有の課題である幻覚(事実に基づかない情報を生成する現象)や、多エージェントシステム(MAS)における調整問題を解決することを目指しています。

研究の意義:効率性と公正性の向上

言語エージェントが集団意思決定に参加することで、意思決定プロセスをより効率的かつ公正にすることが期待されています。言語エージェントは、集団内の多様な意見を迅速かつ客観的に集約し、意思決定の透明性を高めることができます。また、言語エージェントは、人間特有のバイアスや感情的な偏りを排除し、より客観的で公平な意思決定を支援する可能性も秘めています。例えば、会議での発言力が弱いメンバーや、少数派の意見も言語エージェントを通じて平等に反映させることができれば、より包括的で公正な意思決定が実現するかもしれません。さらに、言語エージェントは、ルーチンワークや情報収集といった定型的な意思決定プロセスを自動化し、時間とリソースを大幅に節約することができます。これにより、人間はより複雑で創造的な意思決定に集中できるようになり、組織全体の生産性向上に貢献することが期待されます。特に、大規模な集団や複雑な意思決定シナリオにおいては、言語エージェントの導入効果は大きいと考えられます。

実験の実施と解釈:シミュレーションと実世界応用

言語エージェントが集団意思決定においてデジタル代表として機能する能力を評価するための実験は、シミュレーション環境と実世界での応用実験の両方で実施されています。シミュレーション実験では、言語エージェントが人間と同様の意思決定プロセスを模倣し、集団内の他のメンバーにどのように影響を与えるかを詳細に分析することが可能です。例えば、ある研究では、言語エージェントが仮想的な集団意思決定シミュレーションに参加し、他のエージェント(人間またはAI)とのインタラクションを通じて、意見を交換し、合意形成を目指す実験が行われました。このシミュレーションを通じて、言語エージェントが情報共有を促進し、集団全体の合意形成を効率化する能力が検証されました。

一方、実世界応用実験では、LLaMACフレームワークを用いたシステムリソースの割り当てや、ロボットのグリッド輸送タスクなど、具体的な問題解決における言語エージェントの有効性が検証されています。これらの実験では、言語エージェントが実際の意思決定プロセスにおいて、効率性と効果性を両立できる可能性が示唆されています。

実験結果の解釈においては、言語エージェントが集団意思決定プロセスを効率化し、多様な意見を集約する能力を持つ一方で、倫理的な課題や透明性の確保、実世界の動的な環境への適応能力など、克服すべき課題も存在することが指摘されています。

AIエージェントのパフォーマンスと実装:DLMの活用

言語エージェントのパフォーマンスと実装は、AI技術の進化、特にLLMの進歩とともに向上しています。近年では、LLMを活用したより高度な意思決定能力を持つエージェントが開発されています。例えば、DLM(Decision-Language Model)は、LLMを利用して公共衛生分野におけるリソース割り当てポリシーを動的に調整するエージェントです。DLMは、感染症の流行状況や医療資源の状況などを分析し、最適なリソース配分を自動的に決定することができます。シミュレーション研究を通じて、DLMの有効性が実証されており、現実の公共衛生政策への応用が期待されています。さらに、言語エージェントは、集団意思決定におけるグループダイナミクスにも影響を与える可能性があります。ある研究では、言語エージェントが集団内のコミュニケーションを円滑化し、グループダイナミクスを強化する方法が検討されています。言語エージェントが議論を活性化させたり、意見の対立を緩和したり、合意形成を支援したりすることで、より建設的な集団意思決定プロセスを促進できる可能性があります。

限界と将来の研究方向:倫理、透明性、適応性

言語エージェントの集団意思決定への応用には、多くの可能性が期待される一方で、いくつかの限界と課題も存在します。* **倫理的課題**: AIエージェントが人間の意思決定に影響を与えることに対する倫理的な懸念があります。特に、重要な意思決定プロセスにおいて、AIの判断が偏っていたり、責任の所在が不明確になったりするリスクを考慮する必要があります。

* **透明性の確保**: AIエージェントの意思決定プロセスは、しばしばブラックボックス化しやすく、人間がその判断根拠を理解することが困難な場合があります。意思決定の透明性を確保し、AIの説明責任を果たすための技術開発や制度設計が求められます。

* **実世界の動的環境への適応**: 言語エージェントが、現実世界の複雑で動的な環境にどれだけ適応できるかは、今後の研究課題です。現実世界の状況は常に変化するため、AIエージェントは変化に柔軟に対応し、適切な意思決定を継続的に行う必要があります。

将来の研究方向としては、言語エージェントの倫理的な利用ガイドラインの策定、意思決定プロセスの透明性向上技術の開発、実世界の動的環境における適応能力の向上などが挙げられます。また、言語エージェントが集団意思決定におけるグループダイナミクスにどのように影響を与えるか、より詳細な研究が必要です。これらの研究を通じて、言語エージェントが集団意思決定においてより効果的かつ安全に機能するための基盤が確立されることが期待されます。

結論:AI代弁者の可能性と課題

言語エージェントが集団意思決定におけるデジタル代表として機能する能力は、AI技術の進化とともにますます重要性を増しています。言語エージェントは、意思決定プロセスを効率化し、集団内の多様な意見を集約する可能性を示す一方で、倫理的、技術的な課題も抱えています。高校生を含むAIに関心を持つ読者にとって、これらの研究は、言語エージェントが集団意思決定においてどのように機能し、どのような課題があるかを理解するための重要な情報を提供します。今後の研究開発の進展により、AIエージェントがより安全で信頼性の高い意思決定支援ツールとして社会に貢献することが期待されます。推論モデルとしてのLLM:デモンストレーションからの学習

AIが意見形成の場で人間の代弁者として活動するためには、単に情報を収集・伝達するだけでなく、**複雑な状況を理解し、論理的に推論する能力**が不可欠です。近年、大規模言語モデル(LLM)は、自然言語処理能力だけでなく、高度な推論能力をも獲得しつつあり、その推論メカニズムに関する研究が活発に進められています。特に注目を集めているのが、「LLMs Can Easily Learn to Reason from Demonstrations Structure, not content, is what matters!」という研究です。この研究は、LLMがどのようにして推論能力を学習するのか、そしてその学習プロセスにおいて何が重要なのかについて、驚くべき発見をもたらしました。**AIが単に大量のデータを暗記するのではなく、効率的な学習を通じて、人間のような推論能力を獲得する可能性**を示すこの研究は、LLMの未来、そしてAI全般の可能性を考える上で、非常に重要な意味を持っています。

次のセクションでは、この画期的な研究「LLMs Can Easily Learn to Reason from Demonstrations Structure, not content, is what matters!」の内容を詳しく解説し、**LLMがどのように推論を学習するのか、そしてその学習において「構造」が「内容」よりも重要であるとはどういうことなのか**、その核心に迫ります。この研究を通じて、私たちはAIの推論能力の本質、そしてAIが今後どのように進化していくのかについて、より深く理解することができるでしょう。

概要:LLM推論能力向上の新たな知見

近年、大規模言語モデル(LLM)の発展は目覚ましく、特に推論能力の向上が注目されています。「LLMs Can Easily Learn to Reason from Demonstrations Structure, not content, is what matters!」という研究は、LLMの推論能力向上において重要な発見をもたらしました。この研究は、LLMが効率的な方法で推論能力を獲得できることを示し、特に推論の「構造」が「内容」よりも重要であることを明らかにしました。以下では、この研究の背景、意義、実験内容、そして将来の展望について詳しく解説します。研究の背景と意義:LLM推論能力の課題と革新性

LLMと推論能力の課題:統計的パターンマッチングの限界

大規模言語モデル(LLM)は、膨大なテキストデータから学習し、人間のような自然な文章を生成できる高度なAIモデルです。しかし、従来のLLMは、複雑な推論タスク、特に数学や論理的思考を必要とする問題において、その能力に限界があることが指摘されてきました。LLMは、大量のテキストデータから統計的なパターンを学習する能力に優れているものの、その学習メカニズムは、単なるパターンマッチングに過ぎず、人間のような「理解」に基づいた推論能力を備えているわけではないという批判がありました。研究の重要な意義:効率的な推論学習と構造の重要性

このような背景の中、「LLMs Can Easily Learn to Reason from Demonstrations Structure, not content, is what matters!」研究は、LLMが効率的な方法で推論能力を獲得できることを実験的に示し、LLMの推論能力研究に新たな方向性を示唆しました。特に、この研究の最も重要な発見は、LLMが推論能力を学習する上で、推論の具体的な「内容」よりも、推論プロセスの「構造」の方がはるかに重要であるという点です。この発見は、AIの学習方法に関する従来の考え方を覆し、今後のAI研究開発に大きな影響を与える可能性を秘めています。研究の革新性:少量データでの大幅な性能向上

本研究の革新的な点は、わずか17,000の長いChain-of-Thought(思考の連鎖、以下CoT)トレーニングサンプルという少量のデータを使用して、Qwen2.5-32B-Instructモデルが数学やコーディングのベンチマークで驚異的な性能向上を達成したことです。具体的には、難関な数学コンテストであるAIME 2024で56.7%(+40.0%)、実世界のコーディング能力を評価するLiveCodeBenchで57.0%(+8.1%)という目覚ましい成績を記録しました。これらの結果は、商用モデルであるo1-previewの44.6%と59.1%に匹敵するものであり、本研究で提案された手法の有効性を明確に示すものです。この成果は、LLMが大量のデータに依存せず、少量のデータから効率的に推論能力を学習できる可能性を示唆しており、AIの学習効率と推論能力の向上に新たな道を開くものとして、AI研究コミュニティから大きな注目を集めています。

研究で行われた実験:CoTと構造学習

実験設計と方法論:データ効率的な微調整

研究チームは、データ効率の高い教師あり微調整(Supervised Fine-Tuning、SFT)と、パラメータ効率の高い低ランク適応(Low-Rank Adaptation、LoRA)を組み合わせた、革新的な手法を採用しました。教師あり微調整(SFT)は、既存のLLM(基本モデル)を特定のタスクに適応させるための一般的な手法ですが、大量のトレーニングデータを必要とするという課題があります。一方、低ランク適応(LoRA)は、モデル全体のパラメータを全て調整するのではなく、一部のパラメータのみを効率的に調整することで、少ない計算コストで高い性能向上を実現する手法です。本研究では、SFTとLoRAを組み合わせることで、データ効率とパラメータ効率を両立させ、少量のトレーニングデータでLLMの推論能力を大幅に向上させることを可能にしました。Chain-of-Thought(CoT)トレーニングサンプルの活用

実験では、長いChain-of-Thought(CoT)推論を含むトレーニングサンプルが使用されました。Chain-of-Thought(CoT)とは、複雑な問題を段階的に解決する思考プロセスを模倣し、問題解決の各ステップを自然言語で記述する手法です。CoTトレーニングサンプルは、単に問題と正解のペアを提供するのではなく、問題解決に至るまでの思考過程を詳細に示すことで、LLMが単に答えを暗記するのではなく、問題解決の論理構造そのものを学習することを促します。重要な発見:推論の構造 vs 内容

実験の最も驚くべき発見は、LLMが推論プロセスを学習する上で、個々の推論ステップの「内容」(具体的な計算や知識)よりも、推論全体の「構造」(推論ステップの順序や関係性)の方がはるかに重要であるという点でした。つまり、LLMは、推論の具体的な内容が異なっていても、類似した構造を持つ推論プロセスを効率的に学習し、新たな問題に適用できるということです。この発見は、LLMの学習メカニズムに関する重要な洞察を提供します。LLMは、単に大量の事実や計算を暗記しているのではなく、問題解決のための抽象的な「思考の枠組み」を学習していると考えられます。これは、人間の学習プロセスにも類似しており、特定の問題の解き方を暗記するよりも、問題解決のための一般的なアプローチや思考法を学ぶことの重要性を示唆しています。

実験結果の詳細:数学とコーディングベンチマークでの検証

実験結果は、様々な数学とコーディングのベンチマークで詳細に検証されました。特に注目すべきは、難関数学コンテストであるAIME(American Invitational Mathematics Examination)2024での驚異的な成績向上です。AIIMEは、高校生を対象とした非常に難易度の高い数学コンテストであり、本研究のモデルは、CoTトレーニングによって、正答率を40%も大幅に向上させました。また、実世界のコーディング能力を測定するベンチマークであるLiveCodeBenchでも、8.1%の性能向上を示しました。これらの結果は、本研究で提案されたCoTトレーニング手法が、数学、コーディングといった異なる種類の推論タスクに対して、普遍的に効果的であることを示しています。

研究の解釈と意義:LLM推論の新たな理解と教育的示唆

LLM推論の新たな理解:構造学習の有効性

本研究は、LLMの推論能力に関する従来の理解に根本的な問いを投げかけ、新たな視点を提供しました。従来、LLMは、単に統計的なパターンマッチングを行うだけで、真の「理解」や「推論」は不可能であると考えられてきました。しかし、本研究は、適切な構造化された例(CoTトレーニングサンプル)から学習することで、LLMが驚くほど効果的な推論能力を獲得できることを実証的に示しました。特に重要なのは、LLMが推論の「構造」から学習するという発見です。これは、LLMが単に問題と解答のペアを暗記するのではなく、問題解決のための抽象的な思考プロセスの枠組みを学習していることを強く示唆しています。この視点は、LLMの能力と限界に関する議論に新たな洞察をもたらし、今後のLLM研究の方向性に大きな影響を与える可能性があります。

教育的意義:思考の構造化と枠組みの重要性

本研究の発見は、AI研究だけでなく、人間の教育にも重要な示唆を与えます。問題解決能力を育成する教育において、具体的な問題の解法を個別に教えるだけでなく、問題解決のための思考の構造や枠組みを意識的に教えることの重要性を示唆しています。これは、「魚を与えるのではなく、魚の釣り方を教える」という教育の格言にも通じるものであり、教育方法論における普遍的な原則を、AI研究の観点からも裏付けるものと言えるでしょう。また、本研究は、AIと人間の学習プロセスの類似点と相違点を深く理解する上でも、貴重な洞察を提供しています。AIの学習メカニズムを解明することは、人間の学習プロセスをより深く理解することにも繋がり、教育分野における革新的なアプローチの開発を促進する可能性を秘めています。

AIでの代理人の性能と実施方法:推論型エージェントの可能性

LLMを用いた代理人システム:高度な推論能力の活用

LLMの高い推論能力を最大限に活用する方法として、LLMを「代理人(エージェント)」として活用するアプローチが近年注目されています。AIエージェントとは、特定のタスクを自律的に実行するAIシステムであり、LLMをエージェントとして活用することで、高度な推論能力を必要とする複雑なタスクをAIに実行させることが可能になります。本研究の知見、特に「構造学習」の有効性を活用することで、より効率的かつ高性能な推論型エージェントシステムを構築できる可能性があります。例えば、数学の問題解決、プログラミングのコード生成、複雑なデータ分析、さらには法的文書の解釈や医療診断の支援など、様々な分野で高度な推論能力を持つAIエージェントの開発が期待されています。これらのAIエージェントは、人間が行うには時間と労力がかかる複雑なタスクを自動化し、人間の生産性向上に大きく貢献することが期待されます。

実装方法と技術的詳細:SFT, LoRA, CoTの組み合わせ

本研究で使用された主要な技術は、教師あり微調整(SFT)、低ランク適応(LoRA)、Chain-of-Thought(CoT)プロンプティングです。これらの技術を組み合わせることで、比較的少量のトレーニングデータでも、効果的にLLMの推論能力を向上させることが可能です。特に、推論の構造を強調したCoTトレーニングデータを用意し、SFTとLoRAを用いて効率的にモデルを微調整することが、高性能な推論型エージェントを実装するための重要なポイントとなります。研究の限界と課題:形式推論、忠実性、ハルシネーション

現在の限界:形式推論、忠実性、ハルシネーション

本研究は、LLMの推論能力向上に大きな進展をもたらしましたが、現在のLLMには、依然として克服すべきいくつかの限界と課題が存在します。 * **形式的推論の限界**: LLMは、日常的な推論タスクでは高い性能を発揮するものの、複雑な形式的推論、特に多段階の論理的推論や演繹推論においては、まだ課題を抱えています。例えば、数学の定理証明や論理パズルなど、厳密な論理的思考を必要とするタスクでは、人間の専門家には及ばない場合があります。* **推論の忠実性**: LLMは、Chain-of-Thought(CoT)によって、問題解決の中間的な推論ステップを生成することができますが、生成された推論ステップが、必ずしも論理的に正しく、最終的な答えに忠実に結びついているとは限りません。推論の過程で誤ったステップを踏んだり、論理的な飛躍があったりする可能性があります。

* **ハルシネーション(幻覚)**: LLMは、学習データに存在しない情報を、あたかも事実であるかのように自信を持って生成することがあります。この現象はハルシネーションと呼ばれ、特に推論タスクにおいては、誤った情報に基づいて結論を導き出すリスクがあります。

倫理的考慮事項:誤った推論の影響と透明性

LLMの推論能力が向上するにつれて、その倫理的な影響についても慎重に考慮する必要があります。* **誤った推論の影響**: 高度な推論能力を持つAIが、誤った結論を導き出した場合、特に医療、法律、金融などの重要な分野においては、深刻な影響を及ぼす可能性があります。例えば、医療診断AIが誤診を下したり、法的推論AIが誤った法的解釈を示したりした場合、人々の生命や財産に重大な損害を与える可能性があります。

* **透明性と説明可能性**: LLMの推論プロセスは、しばしばブラックボックス化しやすく、人間がその判断根拠を理解することが困難な場合があります。AIの意思決定プロセスに対する透明性と説明可能性を確保することは、AIの信頼性を高め、社会的な受容を促進するために不可欠です。本研究は、推論の構造の重要性を強調していますが、LLMが学習した推論構造が、常に人間にとって解釈可能であるとは限りません。

未来の研究の方向性:さらなる推論能力向上と応用分野拡大

今後のLLM研究の方向性としては、推論能力のさらなる向上と、応用分野の拡大が期待されています。 * **推論能力のさらなる向上**: 形式的方法との統合、マルチモーダル推論、自己改善メカニズムなどのアプローチによって、LLMの推論能力をさらに向上させる研究が活発に進められています。形式的方法との統合は、LLMの推論能力の厳密性と信頼性を高めることを目指し、マルチモーダル推論は、テキストだけでなく、画像や音声などの複数のモダリティ情報を統合することで、より高度で柔軟な推論能力を実現することを目指します。自己改善メカニズムは、LLMが自身の推論プロセスを分析し、誤りを修正したり、新たな推論戦略を学習したりすることで、継続的に推論能力を向上させることを目指します。* **応用分野の拡大**: 推論能力が向上したLLMは、教育支援、科学研究、医療診断、法的推論など、様々な分野での応用が期待されています。教育分野では、学生一人ひとりの学習状況に合わせて個別指導を行うAIチューターの開発、科学研究分野では、複雑な科学的データの分析や新たな仮説の生成を支援するAI研究アシスタントの開発、医療分野では、患者の症状や検査データから可能性のある疾患を推論するAI診断支援システム、法曹分野では、法律文書の解釈や法的アドバイスを提供するAI法律顧問の開発などが期待されています。

結論:LLM推論研究の新たな地平

「LLMs Can Easily Learn to Reason from Demonstrations Structure, not content, is what matters!」という研究は、LLMの推論能力向上において、画期的な発見をもたらしました。特に、推論の「構造」が「内容」よりも重要であるという知見は、AIの学習と推論に関する従来の理解を大きく変えるものです。本研究は、少量のデータから効率的に学習できるLLMの潜在能力を示し、AI教育と応用研究に新たな道を開きました。しかし、形式的推論の限界や倫理的考慮事項など、解決すべき課題も依然として残されています。今後の研究では、形式的方法との統合やマルチモーダル推論、自己改善メカニズムなどのアプローチによって、LLMの推論能力が飛躍的に向上し、教育、科学研究、医療、法律など、様々な分野でAI応用が拡大していくことが期待されます。

まとめ:AIの進化と未来への展望

AI技術の進展は、目覚ましい速さで進んでおり、その利用状況の分析や、合意形成の場面でのAI活用など、社会の様々な領域でAIの影響力が拡大しています。Anthropic Economic Index の分析を通じて、AIが労働市場に与える影響の実態が明らかになりつつあり、また、言語エージェントの研究は、AIが集団意思決定プロセスを支援する可能性を示唆しています。さらに、LLMの推論能力に関する最新の研究は、AIが効率的な学習を通じて高度な推論能力を獲得できることを示し、AI研究の新たな地平を切り開いています。昨今のReasoningモデルやDeep Researchの仕組みや特徴については、まだ研究が始まったばかりであり、今後の研究動向を注視していくことが、変化の激しい現代社会においてAIと適切に向き合い、その恩恵を最大限に活かしながら、同時に課題にも適切に対処していく上で、私たちにとって重要な姿勢となるでしょう。

by Bantam